웹 브라우저들은 주로 웹 사이트를 크롤링하여 인덱싱을 통해 페이지를 분류하고 검색결과에 뜨게 합니다. 로봇 티엑스티는 텍스트 형식의 파일로 크롤러들이 특정 페이지나 사이트에 접근하지 못하도록 하여 검색창에 뜨지 않도록 하는 기능을 합니다 (다만, 크롤링이 가능한 다른 사이트에 해당 페이지로 이동가능한 링크가 있다면 여전히 접근이 가능하기 때문에 근본적인 접근을 막는 도구는 될 수 없음).

로봇 티엑스티는 사이트맵과 함께 사이트에 대한 접근을 제한하는 공통된 양식으로 강제력은 없지만 대부분의 공신력 있는 브라우저들은 준수하고 있습니다.

주목적은 사이트에 악성 크롤러들이 사이트에 접근하는 것을 사전에 막아 사이트를 보호하는 데 있습니다

사용하기

로봇 티엑스티 파일은 프로토콜 및 포트 단위로 추가되어야 하며 웹사이트 코드의 루트에 추가합니다. 예를 들어할 때 로봇티엑티 파일의 경로는 https://www.eg.com/robots.txt가 되며 https://m.eg.com/robots.txt이나 http://eg.com/robots.txt의 도메인에는 적용되지 않습니다.

파일생성

아래와 같이 텍스트 파일을 생성합니다. 파일명은 반드시 robots이어야 하고 UTF-8을 사용하는 텍스트 파일이어야 합니다. 하나의 사이트는 하나의 robots.txt 파일을 가질 수 있습니다.

robots.txt문법

로봇 파일은 대상과 명령어 그룹으로 구성되며 아래와 같습니다.

▶ 에이전트 지정 (대상지정), 그룹 구분 (필수이며 하나의 그룹 안에 복수 지정가능)

User-agent:▶ 접근제한 구문 (접근제한 또는 접근허용 둘 중 하나는 필수이며 하나의 그룹 안에 복수 지정가능)

Disallow:▶ 접근허용 구문 (기본이 허용이기 때문에 생략 시 허용, 접근제한 또는 접근허용 둘 중 하나는 필수이며 하나의 그룹 안에 복수 지정가능)

Allow:▶ 사이트 맵 구문 (선택이며 하나의 그룹 안에 복수 지정가능)

Sitemap:※ 와일드카드 (*)는 사이트 맵을 제외한 모든 구문에 사용가능하며 사용 시 전체가 허용됩니다 (단, AdsBot 크라울러의 경우 명시적 예외이며 명시적으로 지정필요).

※ 사용되는 경로는 화면에 표시되는 전체경로이어야 하며 디렉터리인 경우 '/'으로 시작해서 '/'으로 끝나야 합니다.

예시,

# Example 1: Block only Googlebot

User-agent: Googlebot

Disallow: /

# Example 2: Block Googlebot and Adsbot

User-agent: Googlebot

User-agent: AdsBot-Google

Disallow: /

# Example 3: Block all crawlers except AdsBot (AdsBot crawlers must be named explicitly)

User-agent: *

Disallow: /robots.txt 파일 만들기 및 제출 | Google 검색 센터 | 문서 | Google Developers

robots.txt 파일은 사이트의 루트에 위치합니다. robots.txt 파일을 만들고 예를 확인하며 robots.txt 규칙을 확인하는 방법을 알아보세요.

developers.google.com

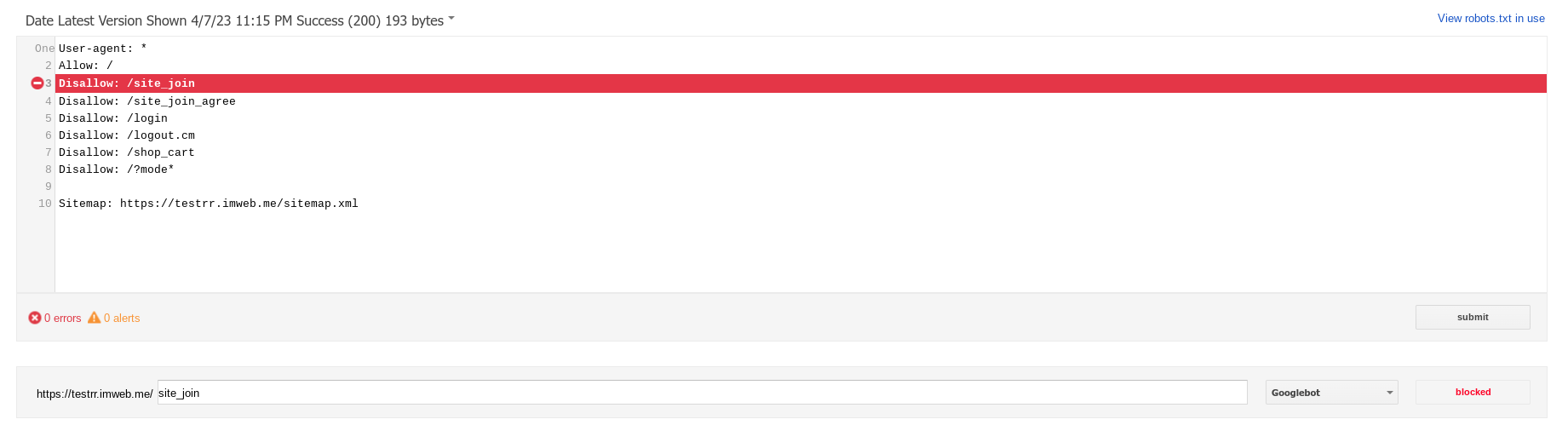

테스트

접근가능한 로봇 파일이 존재하는 구글 서치콘솔 테스터로 접근여부의 시험이 가능합니다

Google Search Console

로그인 Google 검색 콘솔로 이동

accounts.google.com

참고

https://developers.google.com/search/docs/crawling-indexing/robots/intro

robots.txt 소개 및 가이드 | Google 검색 센터 | 문서 | Google Developers

robots.txt는 크롤러 트래픽을 관리하는 데 사용됩니다. robots.txt 소개 가이드에서 robots.txt 파일의 정의와 사용 방법을 알아보세요.

developers.google.com

https://developers.google.com/search/docs/crawling-indexing/robots/create-robots-txt

robots.txt 파일 만들기 및 제출 | Google 검색 센터 | 문서 | Google Developers

robots.txt 파일은 사이트의 루트에 위치합니다. robots.txt 파일을 만들고 예를 확인하며 robots.txt 규칙을 확인하는 방법을 알아보세요.

developers.google.com

https://developer.mozilla.org/en-US/docs/Learn/Common_questions/Web_mechanics/What_is_a_URL

What is a URL? - Learn web development | MDN

With Hypertext and HTTP, URL is one of the key concepts of the Web. It is the mechanism used by browsers to retrieve any published resource on the web.

developer.mozilla.org

'마케팅 및 SEO' 카테고리의 다른 글

| 검색 엔진최적화 (다국어 블로그) (0) | 2023.04.20 |

|---|---|

| 구글 검색 (0) | 2023.03.31 |

| 애널리틱스 측정기준 및 측정항목 (0) | 2023.02.20 |

| 사이트에서 값(가치) 가져오기 (5) | 2023.02.17 |

| GA4 보고서 - 사용자 (1) | 2023.02.16 |